Vous êtes ici

Révolution en vue pour percer les secrets de la matière

Un milliard de milliards d’opérations à la seconde. Les ordinateurs exaflops – du préfixe exa-, 1018, et de flops, qui est le nombre d’opérations en virgule flottante par seconde qu’un ordinateur peut effectuer – offriront cette puissance de calcul colossale, à condition de disposer de programmes et de codes adaptés. Une course internationale est donc en cours non seulement pour fabriquer ces impressionnantes machines, mais aussi pour profiter au maximum de leurs capacités. La Commission européenne finance d’ambitieux projets qui préparent l’arrivée de l’exascale, c’est-à-dire de toute forme de calcul haute performance atteignant l’exaflop. Dans le domaine de la chimie et de la physique des matériaux, Trex1 (pour Targeting real chemical accuracy at the exascale) se focalise sur les méthodes de calcul les plus précises.

Officiellement inauguré en octobre 2020, Trex s’inscrit au sein d’une initiative plus large, EuroHPC, visant à ne pas laisser les États-Unis et la Chine faire cavaliers seuls dans le domaine de l’exaflop. « Les Japonais sont déjà capables aujourd’hui d’atteindre l’exaflop en réduisant la précision des calculs, s’enthousiasme Anthony Scemama, ingénieur de recherche au Laboratoire de chimie et physique quantiques2 et un des deux coordinateurs CNRS de Trex. Nous devons effectuer un gros travail en amont sur les codes pour tirer meilleur profit des machines à venir. »

Prédire le comportement de la matière

L’exascale n’emploiera probablement pas que des processeurs classiques, ou CPU, mais aussi des GPU. Ces processeurs graphiques ont à l’origine été développés pour les jeux vidéo, mais ils rencontrent un succès de plus en plus vif dans les applications de calcul intensif. Là encore, leur utilisation doit s’accompagner d’une réécriture des programmes pour bénéficier pleinement de leur puissance. Mais quelles applications réclament une telle force de frappe ?

« Les chercheurs en chimie disposent déjà de différentes techniques de calcul pour réaliser des simulations, par exemple pour modéliser l’interaction de la lumière avec une molécule, explique Anthony Scemama. Avec Trex, nous nous intéressons aux cas où les méthodes de calcul, décrivant d’une manière réaliste et prédictive les phénomènes physiques qui contrôlent les réactions chimiques, sont trop coûteuses. »

« Trex est un projet transverse, qui inclut aussi des physiciens, souligne Michele Casula, chargé de recherche CNRS et coordinateur de Trex à l’Institut de minéralogie, de physique des matériaux et de cosmochimie3. Nos deux communautés ont besoin de méthodes de calcul assez puissantes pour prédire avec précision le comportement de la matière, ce qui est souvent bien trop gourmand en temps de calcul pour des ordinateurs classiques. »

Modéliser l'eau et maîtriser les matériaux

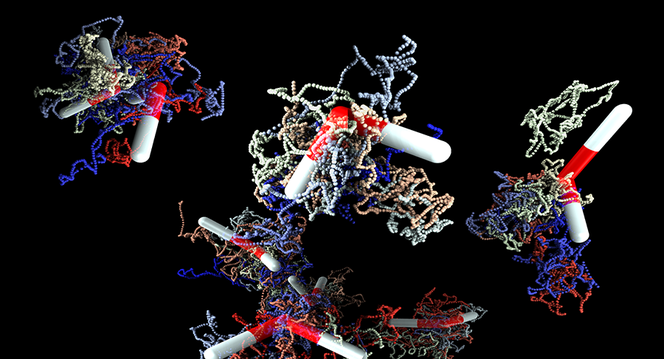

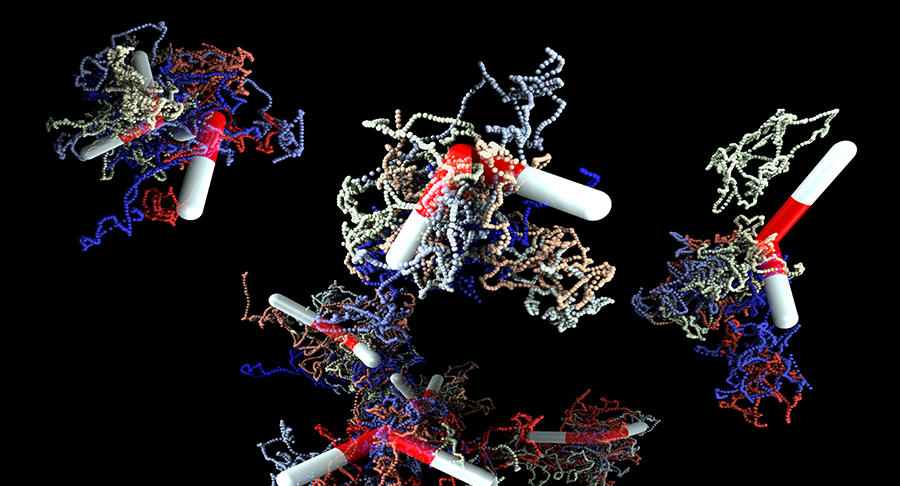

L’équipe de Trex a identifié plusieurs volets d’applications. D’abord, et aussi surprenant que cela paraisse, les propriétés physico-chimiques de l’eau ne sont pas suffisamment bien modélisées. Les simulations ab initio – c’est-à-dire qui partent des interactions fondamentales –, les plus performantes se trompent de plusieurs degrés quand elles tentent d’estimer sa température d’ébullition. Mieux modéliser l’eau permettra par exemple de simuler plus efficacement le comportement des protéines, qui évoluent en permanence dans un milieu aqueux. Ainsi, les applications menées dans le cadre du projet Trex pourraient avoir d’excellentes répercussions sur la recherche en biologie et en pharmacie. Par exemple, la nitrogénase qui contribue de façon essentielle à la vie, transforme l’azote gazeux en ammoniac, une forme que l’organisme peut utiliser. Or, la description théorique des mécanismes physico-chimiques utilisés par cette enzyme n’est pas suffisamment précise avec les modèles actuels.

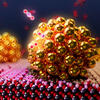

L’exascale doit également aider à comprendre davantage les matériaux fortement corrélés, qui sont caractérisés par les importantes interactions entre les électrons qui les constituent et dont les supraconducteurs font partie. « La compréhension microscopique de leur fonctionnement reste un problème non résolu, qui questionne les scientifiques depuis les années 1980, affirme Michele Casula. Il s’agit d’un des plus grands problèmes encore ouverts pour la physique de la matière. Bien maîtrisés, ces matériaux permettront, entre autres, un transport d’électricité sans perte d’énergie. » Les matériaux 2D sont aussi concernés, en particulier ceux employés dans les panneaux solaires pour la conversion de la lumière en électricité.

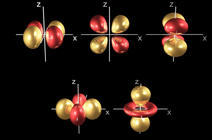

« Si on veut modéliser la matière en utilisant la mécanique quantique, il faut employer des équations, comme celle de Schrödinger, dont le nombre de coordonnées grandit avec le système. Leur complexité augmente de façon exponentielle, précise Michele Casula. Pour parvenir malgré tout à les résoudre dans des simulations, il faudra soit passer par des ordinateurs quantiques, soit explorer davantage la puissance des puces analogiques à silicium avec l’exascale et des algorithmes adaptés. »

« Des millions d'échantillons par seconde »

Pour cela, les membres de Trex misent sur la technique dite du Monte Carlo quantique (Quantum Monte Carlo, QMC), et développent des bibliothèques pour l’intégrer aux codes existants. « On a de la chance d’avoir une méthode qui corresponde aussi bien aux machines exascales », s’exclame Anthony Scemama. Le QMC est en effet particulièrement efficace pour calculer numériquement la valeur d’observables – équivalents quantiques des grandeurs physiques classiques – mettant en jeu des interactions quantiques entre plusieurs particules.

« Le calcul complet de ces observables est trop complexe, insiste Michele Casula, leur estimation précise avec des méthodes déterministes pourrait prendre un temps supérieur à l’âge de l’Univers. Pour faire simple, le QMC ne va pas tout résoudre, mais tire à la place un échantillonnage statistique du résultat. Les ordinateurs exaflops pourront tirer des millions d’échantillons par seconde. Or, grâce à des outils statistiques comme le théorème central limite, plus on a de ces valeurs et plus on s’approche du vrai résultat. Nous obtiendrons ainsi une approximation suffisamment précise pour être utilisée par les chercheurs, et ce en un temps acceptable. »

Dans le cas de l’étude de la matière, une machine exascale permettra alors d’avoir une bonne description du nuage électronique ainsi que son interaction avec les noyaux. Mais ce n’est pas le seul avantage. « Bien configurée, une machine exascale va peut-être consommer trente fois plus qu’un supercalculateur classique, mais elle va fournir en retour mille fois plus de puissance de calcul, estime Anthony Scemama. Les chercheurs pourront par exemple lancer un calcul très coûteux, et en utiliser les résultats afin de bâtir des modèles plus simples pour la suite. »

L’équipe de Trex souligne cependant qu’elle conçoit avant tout des outils techniques et prédictifs pour d’autres chercheurs, qui se chargeront ensuite de développer des applications concrètes. De nombreux échanges permettent d’ailleurs de partager les bonnes pratiques et les retours d’expérience entre les constructeurs de processeurs, les physiciens, les chimistes, les chercheurs en calcul haute performance et les deux centres de calcul de Trex. ♦

Pour en savoir plus :

le site du projet européen Trex

A lire sur notre site

Dans les coulisses de la nouvelle révolution quantique (dossier)

- 1. En français : viser une réelle précision chimique à l’échelle exa-. En plus du CNRS, on retrouve dans le projet les universités de Versailles Saint-Quentin-en-Yvelines, Twente (Pays-Bas), Lodz (Pologne), la SISSA (Italie), l’Institut Max Planck (Allemagne), la SAV (Slovaquie), les centres de calcul CINECA (Italie) et Jülich-Supercomputing Center (Allemagne), ainsi que les entreprises Megware et TRUST-IT.

- 2. Unité CNRS/Université Toulouse Paul Sabatier.

- 3. CNRS/MNHN/Sorbonne Université.

Mots-clés

Partager cet article

Auteur

Diplômé de l’École supérieure de journalisme de Lille, Martin Koppe a notamment travaillé pour les Dossiers d’archéologie, Science et Vie Junior et La Recherche, ainsi que pour le site Maxisciences.com. Il est également diplômé en histoire de l’art, en archéométrie et en épistémologie.

Commentaires

Connectez-vous, rejoignez la communauté

du journal CNRS